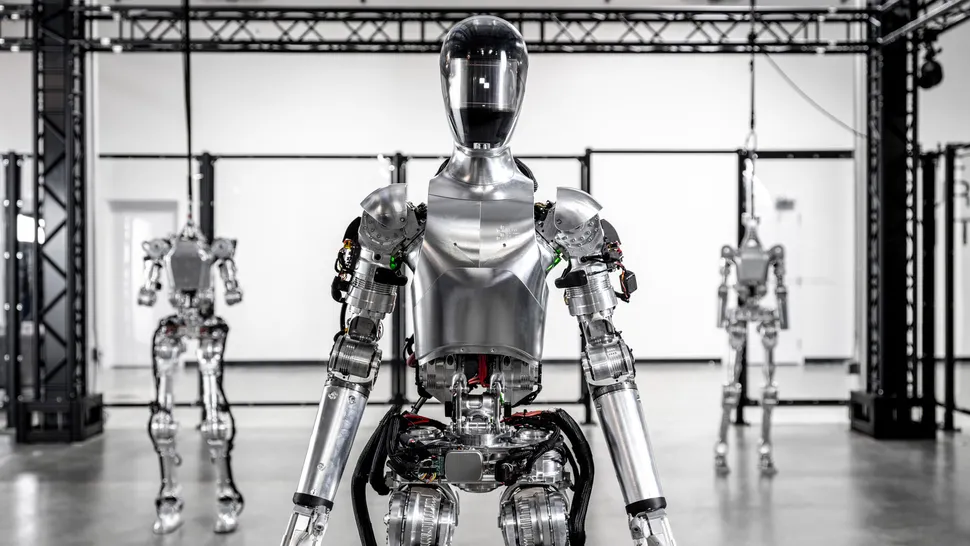

Avec Figure 01, Figure AI dévoile son nouveau modèle de langage visuel (VLM)

La start-up de robotique Figure AI a publié une mise à jour vidéo de son robot Figure 01 exécutant un nouveau modèle de langage visuel (VLM) qui a en quelque sorte transformé le robot d’un automate plutôt inintéressant en un robot de science-fiction à part entière. qui se rapproche des capacités de niveau C-3PO.

La vidéo de Figure 01 est bluffant

Dans la vidéo, Figure 01 se tient derrière une table dressée avec une assiette, une pomme et une tasse. À gauche se trouve un égouttoir. Un humain se tient devant le robot et lui demande : « Figure 01, que voyez-vous en ce moment ? »

Après quelques secondes, Figure 01 répond d’une voix remarquablement humaine (il n’y a pas de visage, juste une lumière animée qui se déplace en synchronisation avec la voix), détaillant tout ce qui se trouve sur la table et les détails de l’homme qui se tient devant elle.

Puis l’homme demande : « Hé, je peux avoir quelque chose à manger ? » Figure 01 répond : « Bien sûr », puis, avec un mouvement fluide et adroit, elle ramasse la pomme et la tend au gars.

Ensuite, l’homme vide des débris froissés d’une poubelle devant le robot en demandant : « Pouvez-vous expliquer pourquoi vous avez fait ce que vous venez de faire pendant que vous ramassiez ces déchets ? »

Figure 01 ne perd pas de temps à expliquer son raisonnement en remettant le papier dans la corbeille. « Alors, je t’ai donné la pomme parce que c’est le seul élément comestible que je pouvais te fournir sur la table. »

Speech-to-speech

La société a expliqué dans un communiqué que Figure 01 s’engage dans un raisonnement « Speech-to-speech » en utilisant le modèle multimodal pré-entraîné d’OpenAI, VLM, pour comprendre des images et des textes et s’appuie sur une conversation vocale entière pour élaborer ses réponses. Ceci est différent, par exemple, du GPT-4 d’OpenAI, qui se concentre sur les invites écrites.

Il utilise également ce que l’entreprise appelle « la manipulation bimanuelle apprise de bas niveau ». Le système associe des étalonnages d’image précis (jusqu’au niveau du pixel) avec son réseau neuronal pour contrôler le mouvement. « Ces réseaux enregistrent des images embarquées à 10 Hz et génèrent des actions à 24 degrés de liberté (poses du poignet et angles des articulations des doigts) à 200 Hz », a écrit Figure AI dans un communiqué.

La société affirme que chaque comportement dans la vidéo est basé sur l’apprentissage du système et n’est pas téléopéré. Ce qui signifie qu’il n’y a personne dans les coulisses. Sans voir Figure 01 en personne et sans poser mes propres questions, il est difficile de vérifier ces affirmations. Il est possible que ce ne soit pas la première fois que la figure 01 exécute cette routine. Cela aurait pu être la 100ème fois, ce qui pourrait expliquer sa rapidité et sa fluidité.

Commentaires

Laisser un commentaire